Qu’est-ce qu’Ollama ?

Ollama est une plateforme open-source permettant d’exécuter et d’intégrer facilement des modèles de langage avancés (LLMs) en local sur un ordinateur ou un serveur. Conçue pour les développeurs et les chercheurs, Ollama simplifie l’utilisation de l’intelligence artificielle sans dépendre d’une infrastructure cloud.

Principales caractéristiques

1. Exécution locale des modèles

Ollama permet de télécharger et d’exécuter des modèles d’intelligence artificielle directement sur une machine locale, garantissant ainsi une exécution rapide, privée et sans dépendance à une connexion Internet.

2. Compatibilité avec plusieurs modèles

La plateforme prend en charge une variété de modèles de langage populaires, notamment ceux basés sur LLaMA, Mistral ou d’autres architectures d’IA, tout en offrant une interface simple pour leur gestion et leur déploiement.

3. Facilité d’utilisation

Avec une interface en ligne de commande intuitive, Ollama permet de charger et d’interagir avec les modèles sans configuration complexe. Une API REST est également disponible pour intégrer facilement les modèles dans des applications.

4. Respect de la confidentialité

Puisque l’exécution des modèles se fait en local, les données traitées ne quittent jamais la machine, ce qui assure une meilleure protection de la vie privée et un contrôle total sur l’utilisation de l’IA.

5. Optimisation des performances

Ollama est conçu pour tirer parti des accélérations matérielles (GPU et CPU) afin d’optimiser l’exécution des modèles et réduire la latence.

Cas d’utilisation

- Développement d’assistants IA personnalisés : Intégration dans des applications pour offrir une assistance contextuelle et adaptée aux utilisateurs.

- Recherche et expérimentation : Test de modèles en local sans nécessité d’utiliser des services cloud coûteux.

- Applications d’entreprise : Traitement de données confidentielles en interne, sans risque de fuite.

- Génération de texte et automatisation : Rédaction automatique, analyse de documents, traduction et bien plus encore.

Comment installer Ollama ?

Installation sous Linux

- Téléchargez et installez Ollama :

curl -fsSL https://ollama.ai/install.sh | sh - Vérifiez l’installation :

ollama --version

Cette installation fonctionne sans problème sur un Raspberry PI5 avec 8 GO de ram

Installation sous Windows

- Téléchargez l’installateur depuis le site officiel : https://ollama.ai

- Exécutez l’installateur et suivez les instructions à l’écran.

- Vérifiez l’installation :

ollama --version

Installation sous macOS

- Téléchargez et installez Ollama via Homebrew :

brew install ollama - Vérifiez l’installation :

ollama --version

Comment utiliser Ollama ?

L’installation d’Ollama est simple et rapide. Voici les étapes de base pour démarrer :

- Charger un modèle :

ollama pull mistral - Interagir avec le modèle :

ollama run mistral - Utiliser l’API REST pour intégrer Ollama dans une application.

Exemple d’utilisation de l’API REST en Python

Voici un exemple de requête simple envoyée à l’API REST d’Ollama en utilisant Python :

Ce script envoie une requête à Ollama pour générer du texte à partir du modèle spécifié et affiche la réponse.Exemple de Chat dans un terminal

Exemple d’exécution

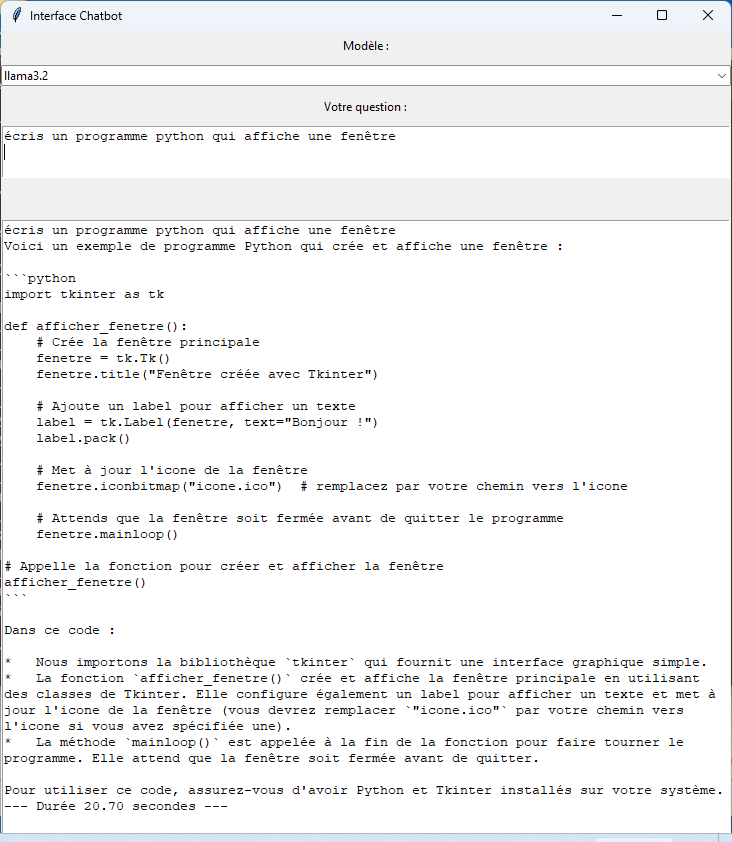

Exemple avec un GUI et sélection de modèles

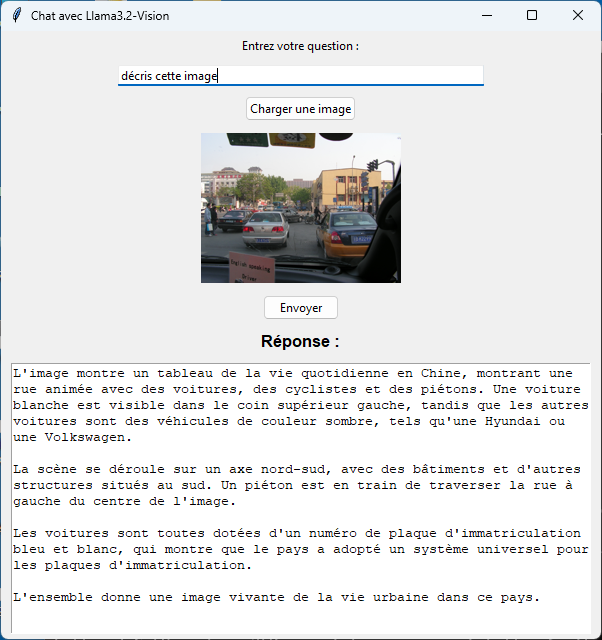

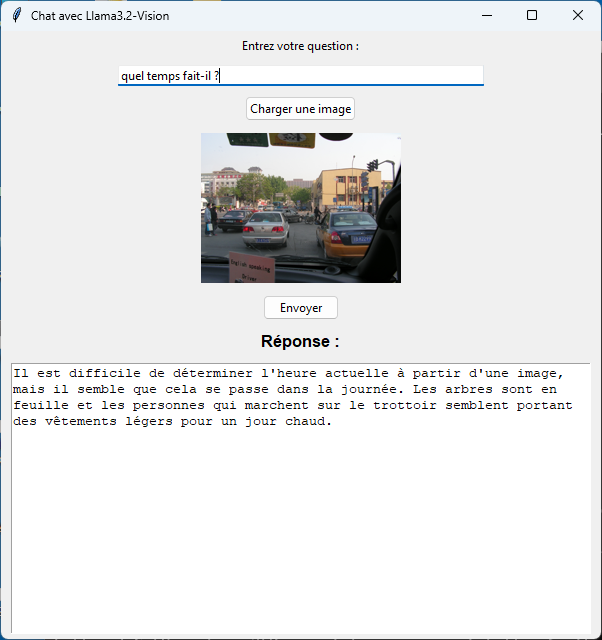

Exemple d’analyse d’images

Le modèle llama3.2-vision permet d’analyser le contenu d’une image.